本人根据MATLAB神经网络的仿真和应用和自己查的文献总结了神经网络的分类,有什么不对的请指出。

1 思维导图

2 引言

可以从不同的角度对人工神经网络进行分类

(1)从网络性能角度可分为连续型与离散型网络、确定性与随机性网络。

( 2)从网络结构角度可为前向网络与反馈网络。

( 3)从学习方式角度可分为有导师学习网络和无导师学习网络。

( 4)按连续突触性质可分为一阶线性关联网络和高阶非线性关联网络。

以下内容主要从网络结构和算法结合的角度对人工神网络进行分类。

3 单层神经网络

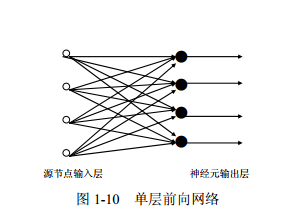

所谓单层前向网络是指拥有的计算节点(神经元)是“单层”的,如图 1-10 所示。这里表

示源节点个数的“输入层”被看做一层神经元,因为该“输入层”不具有执行计算的功能。

4 前馈神经网络

前馈神经网络(feedforward neural network,FNN)

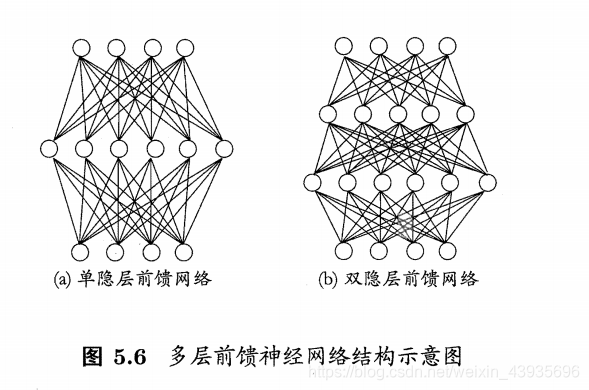

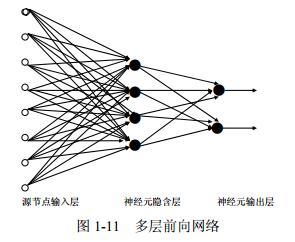

多层前向网络与单层前向网络的区别在于:多层前向网络含有一个或更多的隐含层,其中

计算节点被相应地称为隐含神经元或隐含单元,如图 1-11 所示

4.1 单层前馈神经网 4.1.1 感知器

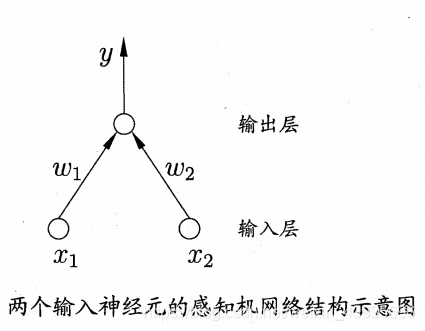

简介: 感知器(Perceptron)由两层神经元组成。如图所示,输入层接收外界输入信号后传递给输出层,输出层是M—P神经元whatsapp网页版,也称为“阈值逻辑单元”。

感知机只有输出层神经元需要激活函数激活,只有一层功能神经元,学习能力非常有限。感知机解决的都是线性可分的问题。要解决非线性可分问题,需要使用多层功能神经元。输出层和输入层之间的神经元成为隐层或者隐含层,隐含层层与输出层神经元都是有激活函数的功能神经元。至此引入多层前馈神经网络。

Matlab函数的使用

4.2 多层前馈神经网络 4.2.1 径向基神经网络

简介: 径向基函数 RBF 神经网络((Radial Basis Function,RBF)是一个只有一个隐藏层的三层前馈神经网络结构,它与前向网络相比最大的不同在于,隐藏层得转换函数是局部响应的高斯函数,而以前的前向网络、转换函数都是全局响应的函数。由于这样的不同,如果要实现同一个功能,RBF 网络的神经元 个数

就可能要比前向 BP 网络的神经元个数要多。 但是,RBF 网络所需要的训练时间却比前向 BP 网络的要少。

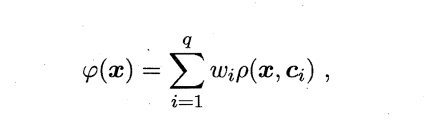

使用径向基函数作为隐层神经元激活函数,而输出层则是对隐层神经元输出的线性组合。假定输入为d维向量x。输出为实值,则RBF网络可以表示为:

其中q为隐层神经元个数,ci和wi分别是第i个隐层神经元所对应的中心和权重,ρ\rhoρ(x,ci)设计径向基函数,这是某种沿径向对称的标量函数,通常定义为样本x到数据中心ci之间欧式距离的单调函数,常用的高斯径向基函数形如

4.2.1.1 广义回归神经网络(General Regression Neural Network,GPNN)

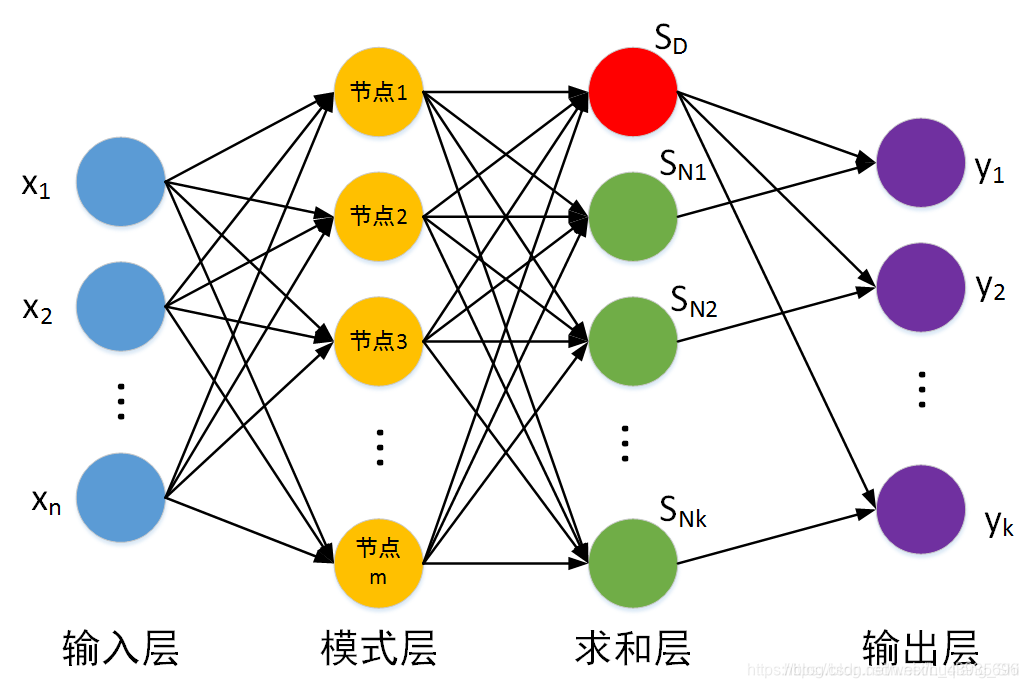

简介:径向基神经元和线性神经元可以建立广义回归神经网络,它是径RBF网络的一种变化形式,经常用于函数逼近。在某些方面比RBF网络更具优势。GRNN与PNN一样也是一个四层的网络结构:输入层、模式层、求和层、输出层。

优点:GRNN具有很强的非线性映射能力和学习速度,比RBF具有更强的优势,网络最后普收敛于样本量集聚较多的优化回归,样本数据少时,预测效果很好, 网络还可以处理不稳定数据。广义回归神经网络对x的回归定义不同于径向基函数的对高斯权值的最小二乘法叠加,他是利用密度函数来预测输出。

与PNN的区别:GRNN用于求解回归问题,而PNN用于求解分类问题。

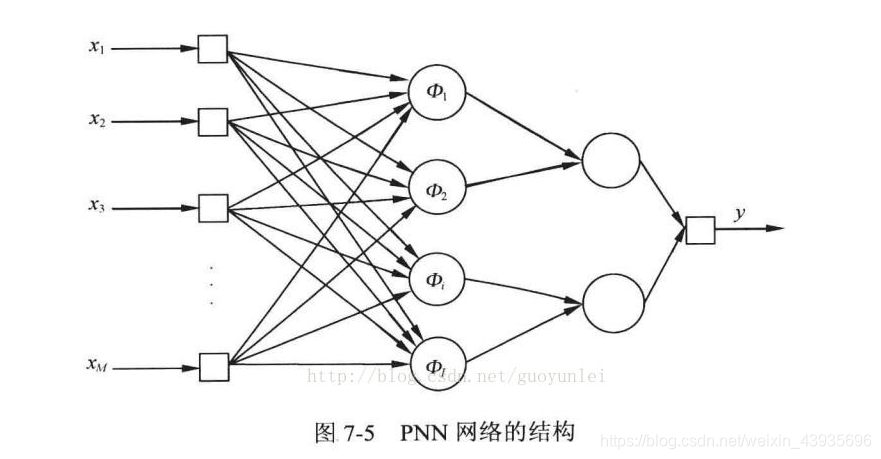

4.2.1.2 概率神经网络(Probabilistic Neural Network,PNN)

简介:径向基神经元和竞争神经元还可以组成概率神经网络。PNN也是RBF的一种变化形式,结构简单训练快捷,特别适合于模式分类问题的解决。理论基础是贝叶斯最小风险准则,即是贝叶斯决策理论。

结构:由输入层、隐含层、求和层、输出层组成。也把隐含层称为模式层,把求和层叫做竞争层

第一层为输入层,用于接收来自训练样本的值,将数据传递给隐含层,神经元个数与输入向量长度相等。

第二层隐含层是径向基层,每一个隐含层的神经元节点拥有一个中心,该层接收输入层的样本输入,计算输入向量与中心的距离,最后返回一个标量值,神经元个数与输入训练样本个数相同。

优点:

4.2.2 BP神经网络(Back Propagation,BP)

强化多层神经网络的训练,必须引入算法,其中最成功的是误差逆传播算法(Back Propagation,简称BP算法)。BP算法不仅用于多层前馈神经网络whatsapp网页版,还可以用于训练递归神经网络。解决了多层神经网络隐含层连接权学习问题,并在数学上给出了完整推导。人们把采用这种算法进行误差校正的多层前馈网络称为BP神经网络

BP神经网络网络主要四个方面的应用:

1)函数逼近:用输入向量和相应的输出向量训练一个网络逼近一个函数。

2)模式识别:用一个待定的输出向量将它与输入向量联系起来。

3)分类:把输入向量所定义的合适方式进行分类。

4)数据压缩:减少输出向量维数以便于传输或存储。

4.2.3 全连接神经网络

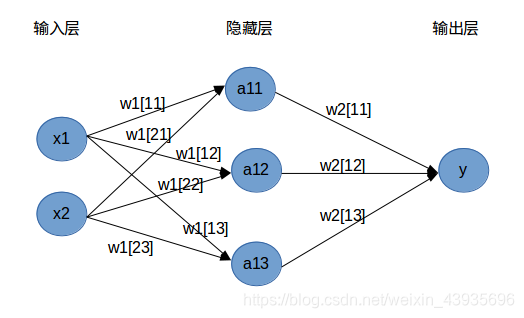

全连接神经网络(fully connected neural network),顾名思义,就是相邻两层之间任意两个节点之间都有连接。全连接神经网络是最为普通的一种模型(比如和CNN相比),由于是全连接,所以会有更多的权重值和连接telegram中文版,因此也意味着占用更多的内存和计算。

如图定义了一个两层的全连接神经网络。

4.2.4 卷积神经网络(Convolutional Neural Networks, CNN)

参考本人的另一篇博客

卷积神经网络CNN(Convolutional Neural Networks, CNN) 综述

4.3 线性神经网络

线性神经网络详细原理及MATLAB实现pdf

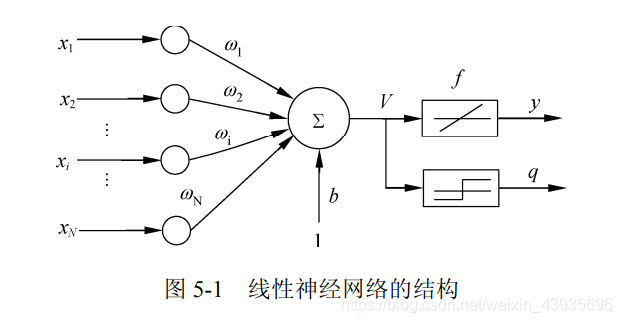

简介: 线性神经网络最典型的例子是自适应线性元件(Adaptive Linear Element,Adaline)。自适应线性元件 20 世纪 50 年代末由 Widrow 和 Hoff 提出,主要用途是通过线性逼近一个函数式而进行模式联想以及信号滤波、预测、模型识别和控制等。

线性神经网络与感知器的主要区别:

感知器的传输函数只能输出两种可能的值,而线性神经网络的输出可以取任意值,其传输函数是线性函数。线性神经网络采用

Widrow-Hoff 学习规则,即 LMS(Least Mean Square)算法来调整网络的权值和偏置。线性神经网络在收敛的精度和速度上较感知器都有了较大提高,但其线性运算规则决定了它只能解决线性可分的问题。

线性神经网络在结构上与感知器网络非常相似,只是神经元传输函数不同。

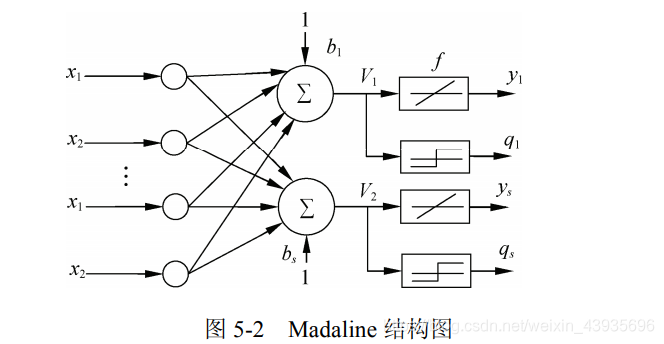

4.3.1 Madaline 神经网络

若网络中包含多个神经元节点,就能形成多个输出,这种线性神经网络叫Madaline神经网络。

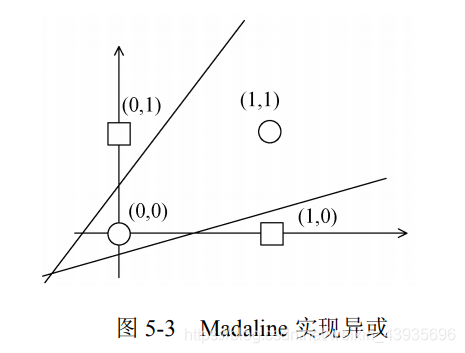

Madaline 可以用一种间接的方式解决线性不可分的问题,方法是用多个线性函数对区域进行划分,然后对各个神经元的输出做逻辑运算。如图所示,Madaline 用两条直线实现了异或逻辑。

5 反馈型神经神经网络

所谓反馈网络是指在网络中至少含有一个反馈回路的神经网络。反馈网络可以包含一个单层神经元,其中每个神经元将自身的输出信号反馈给其他所有神经元的输入

反馈神经网络中神经元不但可以接收其他神经元的信号,而且可以接收自己的反馈信号。和前馈神经网络相比,反馈神经网络中的神经元具有记忆功能,在不同时刻具有不同的状态。反馈神经网络中的信息传播可以是单向也可以是双向传播,因此可以用一个有向循环图或者无向图来表示。

5.1 递归神经网络(Recurrent neural network,RNN)

与前馈神经网络不同"递归神经网络" (recurrent neural networks)允许网络中出现环形结构,从而可让一些神经元的输出反馈回来作为输入信号.这样的结构与信息反馈过程,使得网络在 t 时刻的输出状态不仅与 t 时刻的输入有关,还与 t - 1 时刻的网络状态有关,从而能处理与时间有关的动态变化。

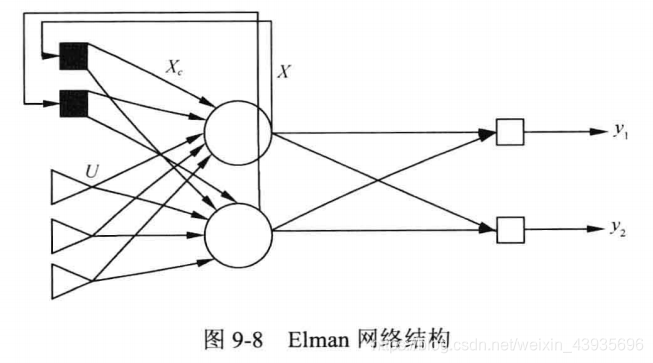

5.1.1 Elman网络

(1)简介

基本的Elman伸进网络由输入层、隐含层、连接层、输出层组成。与BP网络相比,在结构上了多了一个连接层,用于构成局部反馈。

(2)特点

连接层的传输函数为线性函数,但是多了一个延迟单元,因此连接层可以记忆过去的状态,并在下一时刻与网络的输入一起作为隐含层的输入,使网络具有动态记忆功能,非常适合时间序列预测问题。